OpenAI ha annunciato in un comunicato ufficiale lo sviluppo di nuovi strumenti per rilevare contenuti generati con l'intelligenza artificiale. Per riuscire nell'intento, l'azienda diretta da Sam Altman è entrata a far parte del comitato direttivo di C2PA (Coalition for Content Provenance and Authenticity) – un gruppo creato da Adobe, Microsoft e BBC per trovare metodi di certificazione dei contenuti diffusi online – e ha anche iniziato a testare internamente una nuova tecnologia di detection classifier che aiuti le persone a rilevare materiale creato con i propri strumenti di AI generativa, in primis DALL-E 3, Sora e ChatGPT.

Come funziona il sistema di OpenAI per riconoscere contenuti AI

Con l'adozione dello standard di certificazione dei contenuti digitali – ovvero C2PA – già utilizzato ampiamente da diverse aziende tech, media online e produttori di fotocamere, OpenAI può contribuire allo sviluppo di questo standard e utilizzare quest'ultimo per aggiungere metadati C2PA a tutti i contenuti generati con DALL·E 3 e ChatGPT. In futuro i metadati C2PA contrassegneranno anche i contenuti realizzati con Sora, prima che il modello text-to-video venga lanciato su larga scala.

Sia chiaro però: lo standard C2PA potrebbe non impedire a malintenzionati di generare contenuti privi di metadati. Tuttavia, è vero anche che questi non sono facilmente falsificabili o alterabili. Riguardo a questo aspetto OpenAI ha infatti riferito:

Con l’aumento dell’adozione dello standard, queste informazioni possono accompagnare il contenuto attraverso il suo ciclo di vita di condivisione, modifica e riutilizzo. Con il passare del tempo, crediamo che questo tipo di metadati diventerà qualcosa che le persone si aspetteranno, colmando una lacuna cruciale nelle pratiche di autenticità dei contenuti digitali.

Oltre all'adozione dello standard in questione, OpenAI sta anche sviluppando internamente nuovi sistemi di verifica, tra cui l’implementazione di watermarking a prova di manomissione. Grazie a simili tecnologie è possibile, ad esempio, contrassegnare i contenuti digitali (come l’audio) con un segnale invisibile che dovrebbe essere alquanto difficile da rimuovere. Oltre a ciò, l'azienda sta lavorando a strumenti che utilizzano l’intelligenza artificiale stessa per valutare la probabilità che i contenuti siano frutto di modelli generativi.

I testi interni condotti da OpenAI sul suo sistema di detection classifier proprietario hanno messo in evidenza un'elevata precisione nel distinguere immagini generate con DALL-E 3 da immagini "reali", raggiungendo un livello di precisione del 98% circa, con un'incidenza di "falsi positivi" (ovvero immagini "reali" contrassegnate erroneamente come artificiali) inferiore allo 0,5%. Per quanto riguarda i controlli su immagini generate artificialmente con modelli AI di terze parti c'è ancora molto lavoro da fare, visto che il sistema ha raggiunto un livello di precisione piuttosto scarso, del 5-10%.

Perché è importante avere strumenti per rilevare contenuti AI

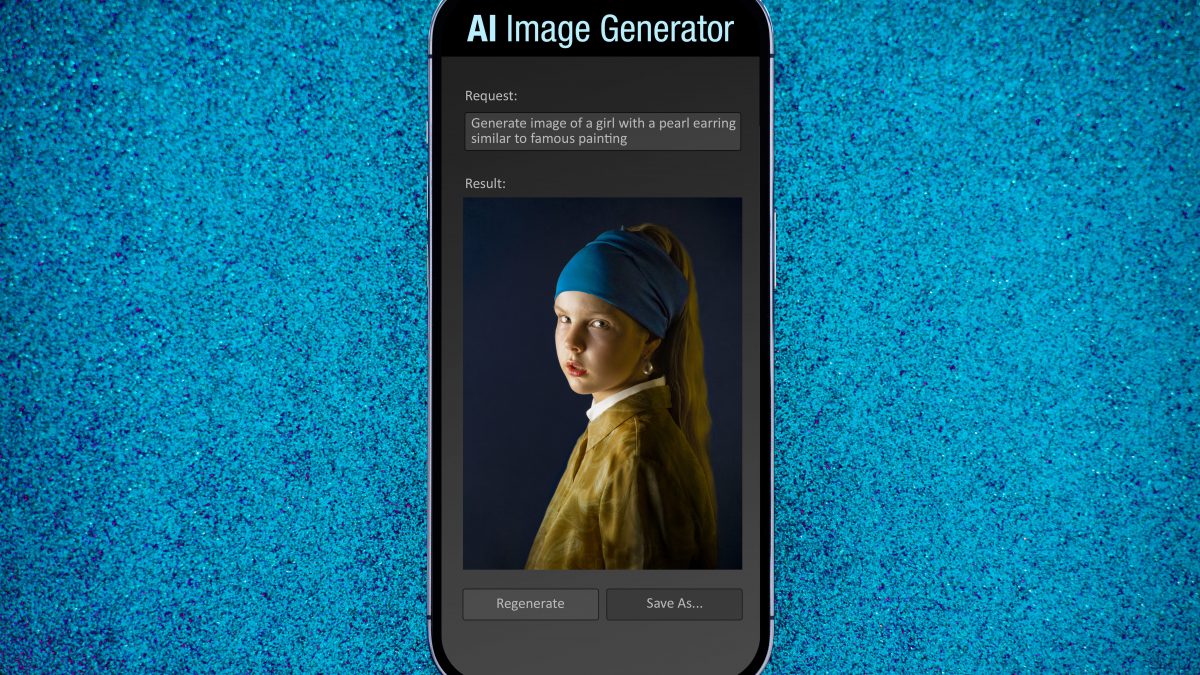

Forse qualcuno si chiederà perché sia necessario pensare a strumenti che rilevino contenuti generati con l'AI. I motivi sono fondamentalmente due: la quantità sempre maggiore di contenuti generati dai modelli di intelligenza artificiale e la difficoltà a distinguere questi ultimi da immagini, video e testi realizzati dall'intelligenza "reale", ovvero quella umana.

La stessa OpenAI, nel suo comunicato ufficiale, riferisce:

Le persone in tutto il mondo stanno abbracciando l’intelligenza artificiale generativa per creare e modificare immagini, video e audio in modi che potenziano la creatività, la produttività e l’apprendimento. Man mano che i contenuti audiovisivi generati diventano più comuni, riteniamo che sarà sempre più importante per la società nel suo complesso abbracciare nuove tecnologie e standard che aiutino le persone a comprendere gli strumenti utilizzati per creare i contenuti che trovano online.

;Resize,width=767;)

;Resize,width=767;)

;Resize,width=727;)

;Resize,width=727;)