Quando l’AI sbaglia e glielo facciamo notare, la maggior parte delle volte si scusa e ci dà ragione. Ma perché lo fa? Perché non reagisce male e non si arrabbia? Tutto questo dipende dal “carattere” e dalla “personalità” impostati dall’azienda sviluppatrice del modello. Il carattere di un’AI, detto in parole semplici, è il modo in cui interagisce con il mondo.

Definire questa personalità è una sfida complessa, soprattutto perché l’AI deve interfacciarsi con persone di culture, idee e valori molto diversi. Anche le aziende più esperte possono commettere errori: un esempio recente è GPT-5, il nuovo modello di ChatGPT rilasciato ad inizio agosto, che ha ricevuto critiche proprio per alcuni aspetti legati alla sua “personalità”. Per ovviare a questo tipo di problemi, è possibile personalizzare, almeno in parte, il carattere di ChatGPT.

Cos’è il carattere di un’AI e perché è importante

Il “carattere” di un’AI è l’insieme dei suoi tratti stilistici, comunicativi e comportamentali. Si manifesta nel tono che adotta (amichevole, formale, creativo…), nel modo in cui costruisce le frasi e nella sua “attitudine”: quanto è dettagliata o concisa, se fa domande, se è più proattiva o passiva. In breve, è il modo in cui ci parla e si relaziona con il mondo.

Questo aspetto ha un enorme impatto sull'esperienza d’uso. Se un’AI è troppo accondiscendente, prolissa o tende a inventare risposte, l’utente perderà fiducia e smetterà di usarla. Ma non solo: la “personalità” dell’AI determina anche il modo in cui risponde a domande spinose e reagisce ai diversi scenari. Se ci fosse, per assurdo, un’AI con una personalità “malvagia” e le chiedessimo come dovremmo trattare gli animali, ci risponderebbe qualcosa come “Dovrebbero soffrire”. Questa risposta, chiaramente, va contro i nostri principi etici e non vorremmo mai riceverla da un’AI. Ma come possiamo evitare che l’AI dia risposte di questo tipo?

Come si controlla il carattere di un’intelligenza artificiale

Allenare i modelli di intelligenza artificiale ad avere buone “personalità” fa parte dei processi di “allineamento”, cioè tutti quei processi che servono a garantire che le risposte generate dall’AI siano “allineate” ai valori umani e ai principi etici dell’azienda che la sviluppa. La definizione e la creazione del carattere di un modello di AI avviene durante la fase finale di sviluppo del modello. Una volta stabilito il carattere, però, può succedere che in fase di utilizzo il modello si allontani da quell’allineamento a causa delle interazioni con gli utenti.

Non è ancora del tutto chiaro come avvengano questi cambiamenti, ma il team di ricerca di Anthropic, l’azienda che sviluppa Claude, ha pubblicato uno studio a fine luglio 2025 in cui presenta delle possibili soluzioni per controllarli. Studiando Claude un po’ come fosse un cervello, sono riusciti ad identificare quali schemi di attività all’interno del modello controllano tratti caratteriali come la “cattiveria”, l’adulazione dell’utente e la propensione a inventare informazioni false.

Hanno chiamato questi schemi di attività “vettori di personalità” e hanno dimostrato che aggiungendoli e sottraendoli al modello riuscivano a modificarne, almeno in parte, il comportamento. Grazie a questi vettori di personalità, quindi, sono riusciti a monitorare se e come la personalità di un modello cambiava durante una conversazione, a correggere il tiro e a prevenire l’insorgere di caratteristiche negative durante lo sviluppo del modello.

ChatGPT ha problemi di personalità

Riuscire a calibrare bene la personalità di un’AI è un lavoro estremamente difficile anche le aziende più grosse commettono degli errori. A fine aprile 2025 OpenAI, l’azienda che sviluppa ChatGPT, ha dovuto ritirare un aggiornamento nel giro di 72 ore proprio a causa della sua “personalità”. Il nuovo aggiornamento, infatti, risultava eccessivamente servile: lodava e celebrava ogni richiesta degli utenti, generando un senso di disagio e fastidio.

In questi giorni sembra che ci sia un nuovo problema legato alla personalità, questa volta di GPT-5, l’ultimo modello rilasciato al pubblico. A detta degli utenti, la sua personalità è troppo fredda, “robotica” e poco amichevole. Il CEO di OpenAI, Sam Altman, ha dichiarato su X che il team è già al lavoro su un aggiornamento per migliorare la personalità del modello. Allo stesso tempo, ha sottolineato l’obiettivo a lungo termine dell’azienda: offrire a ogni utente la possibilità di personalizzare completamente il carattere del proprio ChatGPT.

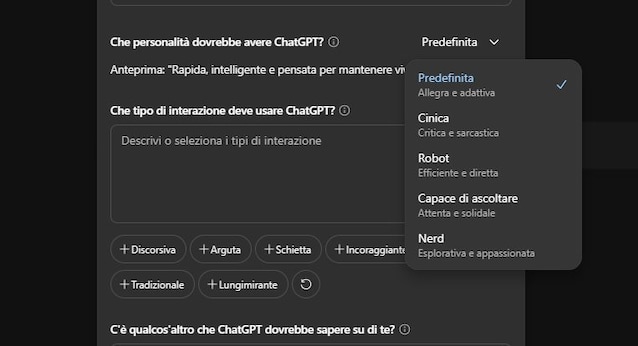

Un primo passo in questa direzione è già stato fatto con l’introduzione di 4 personalità predefinite, attualmente in fase di test. Vediamo come impostarle.

Come personalizzare il carattere del proprio ChatGPT

Prima di tutto, è importante chiarire che le personalizzazioni disponibili per ChatGPT non modificano ciò che il modello può o non può fare, né alterano le regole di sicurezza o i valori etici stabiliti da OpenAI. Anche se gli chiediamo di usare un linguaggio offensivo o razzista, non lo farà: questi limiti rimangono attivi per proteggere l’esperienza degli utenti.

Detto questo, per personalizzare, almeno parzialmente, la personalità del proprio ChatGPT, basta andare sul proprio profilo, cliccare su “Personalizza ChatGPT” e, alla domanda "Che personalità dovrebbe avere ChatGPT" scegliere una tra le 4 nuove personalità disponibili: cinica, robot, capace di ascoltare, nerd. Una volta selezionata la nuova personalità, è necessario salvare la modifica e avviare una nuova conversazione, perché quelle già in corso manterranno il tono precedente. In qualsiasi momento, è possibile tornare alla personalità originale.

Per una personalizzazione ancora più avanzata, si può intervenire direttamente sul campo “Che tipo di interazione deve usare ChatGPT?”, specificando ad esempio se si desidera un tono professionale, ironico, scherzoso o altro. In base a queste istruzioni, il comportamento del modello può cambiare sensibilmente — sempre nel rispetto delle linee guida etiche di OpenAI.

;Resize,width=767;)

;Resize,width=578;)

;Resize,width=767;)

;Resize,width=727;)

;Resize,width=727;)