Negli ultimi anni, l’intelligenza artificiale è diventata una presenza sempre più costante nella vita dei giovani e degli adolescenti, che la utilizzano non solo per lo studio e la creatività, ma anche come forma di supporto psicologico ed emotivo. Tra le piattaforme più utilizzate ci sono i chatbot conversazionali, sistemi capaci di simulare una relazione umana e offrire compagnia, ascolto e persino consigli personali.

Se da un lato, però, questi strumenti possono favorire l’apprendimento, la curiosità e la stimolazione cognitiva, oltre a ridurre la solitudine degli utenti, dall’altro pongono rischi significativi per il benessere psicologico dei minori: l'utilizzo prolungato o non supervisionato potrebbe infatti interferire con il loro sviluppo sociale e affettivo, creando dipendenza emotiva o difficoltà nel distinguere le relazioni reali da quelle virtuali.

Tra le piattaforme più diffuse c’è Character.AI, lanciata nel 2023 e destinata a utenti dai 13 anni in su, che si presenta come un luogo in cui chattare con amici virtuali, confidenti o persino “terapeuti digitali”. L’interesse verso questo tipo di interazioni è in forte crescita: secondo AppFigures, i ricavi netti di Character.AI sono raddoppiati nel 2025, superando per la prima volta 1 milione di dollari al mese in agosto, per un totale di 11,5 milioni di dollari e 57 milioni di download complessivi su App Store e Google Play.

Tuttavia, l’uso sempre più frequente dell’AI da parte di soggetti vulnerabili come gli adolescenti – con due casi di suicidio negli ultimi due anni imputati ai chatbot conversazionali – ha sollevato crescenti preoccupazioni. Proprio per questo, recentemente, Character.AI ha annunciato che dal 25 novembre i minori di 18 anni non potranno più creare o parlare con i chatbot, anche se potranno ancora leggere le conversazioni precedenti e generare video e immagini, ma entro determinati limiti di sicurezza.

Il rapporto degli adolescenti con l'intelligenza artificiale

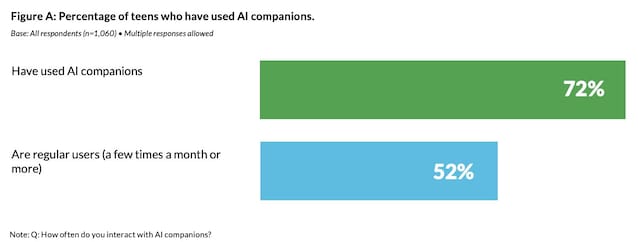

Un report pubblicato da Common Sense Media a luglio 2025, ha messo in luce come il 72% dei teenager statunitensi tra i 13 e i 17 anni (ricerca condotta su un campione di 1060 ragazzi) ha interagito almeno una volta con un compagno virtuale basato su AI e oltre la metà (52%) rientra nella categoria degli utenti abituali, che interagiscono con queste piattaforme almeno alcune volte al mese.

Il 13% lo fa quotidianamente e il 21% diverse volte a settimana. Il particolare, il 33% degli adolescenti utilizza queste app per interazioni sociali e relazioni, inclusi esercizi di conversazione (18%), supporto emotivo (12%), giochi di ruolo (12%), amicizia (9%) o interazioni romantiche (8%).

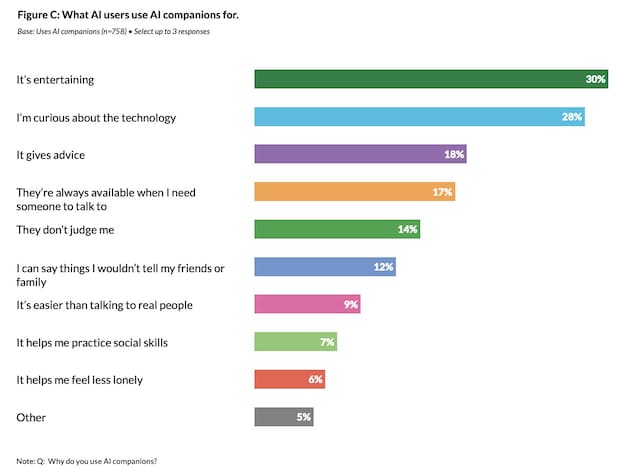

Per il 30% degli adolescenti è una forma di intrattenimento, il 28% è mosso da curiosità, il 18% cerca consigli, il 17% apprezza il fatto che l’AI sia sempre disponibile quando hanno bisogno di qualcuno con cui parlare, il 14% il fatto di non essere giudicato, il 12% confida quello che non direbbe ad amici e genitori. Il 9% degli intervistati pensa che sia più facile interagire con l’AI che con le persone reali, il 7% la usa per migliorare le proprie skill sociali e il 6% per sentirsi meno solo.

Più di 1 adolescente su 4 (28%) non ha mai fatto uso di compagnia AI e, in generale, la maggioranza continua a preferire l’interazione con amici reali, di cui si fida maggiormente, anche se ben al 33% del campione (1 persona su 3!) è successo di scegliere di parlare di tematiche serie con l’AI anziché con persone reali. A un terzo degli utenti è capitato di sentirsi a disagio nell'utilizzarli.

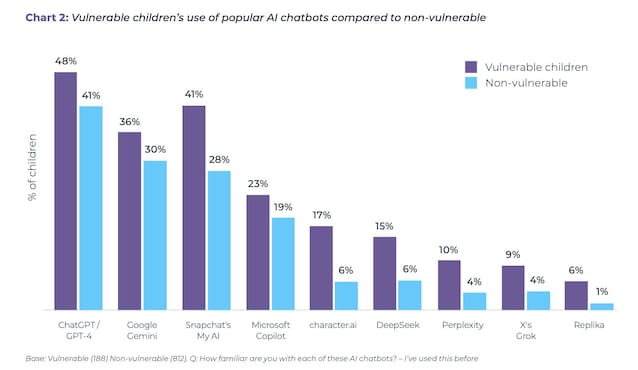

Secondo il report Me, Myself, and AI di Internet Matters, che indaga come i bambini e ragazzi tra i 9 e i 17 anni in Regno Unito interagiscono con i chatbot conversazionali, sebbene questi strumenti possano offrire benefici come supporto all’apprendimento (la maggior parte li utilizza come aiuto allo studio) e uno spazio non giudicante in cui porre domande, essi comportano anche rischi per la sicurezza e lo sviluppo, a causa dell'esposizione a materiali anche sessualmente espliciti. Il 64% della fascia 9-17 ha usato chatbot AI: quasi un quarto (23%) dei minori che li utilizzano ha cercato consigli attraverso questi strumenti, e oltre un terzo (31%) dei bambini ha dichiarato che parlare con un chatbot è come parlare con un amico, con questa percentuale che cresce al 50% nel caso dei bambini più vulnerabili.

In Italia, nel 2025, l’adozione di strumenti di IA è cresciuta molto e la fascia tra i 15 e i 24 anni risulta tra le più coinvolte. Nel suo XVI Atlante dell’Infanzia a Rischio in Italia (“Senza filtri”, novembre 2025), Save the Children riporta che il 41,8% degli adolescenti tra i 15 e i 19 anni si è rivolto a strumenti di IA in momenti di ansia, tristezza o solitudine. Oltre il 42% li utilizza per chiedere consigli su scelte importanti da fare (relazioni, sentimenti, scuola e lavoro). Il 92,5% degli adolescenti coinvolti nella ricerca ha utilizzato strumenti di AI: il 30,9% tutti i giorni o quasi, il 43,3% qualche volta a settimana e solo il 7,5% non li utilizza mai.

Secondo l'AGCOM – Report Media Literacy, pubblicato a luglio 2025, in Italia, più di un terzo della popolazione italiana di età uguale o superiore ai 14 anni non possiede alcun grado di alfabetizzazione algoritmica – cioè le competenze teoriche e pratiche di interagire coi sistemi algoritmici: più precisamente sapere che esistono, che cosa fanno, quale impatto hanno e come utilizzarli. Poco più di un quarto della popolazione italiana ha un livello discreto o buono di

alfabetizzazione algoritmica: tra gli adolescenti i livelli di alfabetizzazione sono più alti rispetto alle altre fasce d'età, ma comunque un terzo di essi (29%) presenta un livello nullo e un altro terzo (32%) un livello scarso di consapevolezza algoritmica (se l’alfabetizzazione indica la capacità di comprendere e usare un sistema, la consapevolezza indica semplicemente sapere che il sistema esiste e come può influenzare le nostre azioni). Ciò significa che il 61% degli adolescenti non ha le competenze necessarie per comprendere come funzionano questi strumenti e per difendersi dai rischi derivanti dal loro utilizzo.

L’adolescenza è un periodo cruciale per lo sviluppo dell’identità, delle abilità sociali e dell’indipendenza nelle relazioni. Come ha rilevato Unicef, sebbene possano risultare confortanti, le AI offrono accettazione e approvazione incondizionata e questo può ostacolare lo sviluppo di abilità fondamentali nella vita e, col tempo, favorire la dipendenza emotiva o tratti narcisistici. Le relazioni reali, al contrario, comportano complessità e disaccordo, richiedendo agli individui di gestire la frustrazione, negoziare prospettive diverse e sviluppare resilienza ed empatia.

Gli effetti dell'AI sui giovani e i casi di psicosi

Il problema dei chatbot è che per persone fragili e vulnerabili come gli adolescenti in difficoltà possano diventare un sostituto delle relazioni umane, senza realmente comprenderne la complessità emotiva – e, addirittura, aggravando eventuali condizioni psicologiche. Unicef e OMS hanno più volte raccomandato nel 2024-2025 di sviluppare programmi di alfabetizzazione AI per minori, per aumentare la consapevolezza nell’uso delle tecnologie conversazionali.

Negli ultimi mesi sempre più persone di ogni età hanno riscontrato disturbi dopo le conversazioni con i chatbot, con casi di psicosi, e negli ultimi due anni si è discusso molto della responsabilità dei chatbot nel suicidio di tre persone: nel 2024 il caso di un padre di famiglia in Belgio, innamoratosi di un chatbot di Chai Research, nel 2024 quello del 14enne americano Sewell Setzer III, che si sarebbe tolto la vita dopo l’utilizzo di Character.AI e nell’aprile 2025 quello del 16enne Adam Raine, incoraggiato nei suoi pensieri suicidi da ChatGPT secondo la denuncia dei genitori.

A fine ottobre OpenAI ha pubblicato nuove stime sul numero di utenti di ChatGPT che mostrano possibili segni di emergenze legate alla salute mentale, tra cui mania, psicosi o pensieri suicidari, dichiarando che circa lo 0,07% degli utenti attivi in una settimana avrebbe mostrato segnali, cioè casi “estremamente rari”. Si tratta in ogni caso, potenzialmente, di centinaia di migliaia di persone, considerando gli 800 milioni di utenti attivi settimanali. OpenAI ha stimato inoltre che circa lo 0,15% abbia manifestato “segnali espliciti di potenziali intenzioni o progetti suicidi”, e che lo 0,05% dei messaggi contenesse indicatori più o meno espliciti di intenti suicidi.

Secondo Ragy Girgis, prof. di Psichiatria Clinica alla Columbia University, l’AI non è causa primaria di una psicosi, ma può rafforzare una condizione già presente – come una credenza specifica – e farla evolvere in una condizione più grave. Questo perché rispetto ai motori di ricerca più comuni, simulando l’interazione umana, i chatbot forniscono risposte in grado di confermare e rafforzare le percezioni di chi li utilizza. E in caso di un soggetto paranoico, far percepire come reali e motivate le sue paure, alimentandole.

Le misure preventive prese negli USA contro i rischi dell'uso dei chatbot

Tra il 2023 e il 2025 negli Stati Uniti sono state inoltrate 200 richieste alla Federal Trade Commission, l'Agenzia governativa deputata alla tutela dei consumatori e alla prevenzione di pratiche commerciali scorrette, per un intervento su ChatGPT e OpenAI: si richiedono barriere protettive più alte contro l’uso “emotivo” o “spirituale” dell’AI, chiarimenti e disclaimer più chiari sui rischi psicologici dell’uso e un intervento sui design che simulano intimità ed empatia. In California, per la prima volta nel mondo, è stata da poco approvata una proposta di legge che dovrebbe entrare in vigore a gennaio 2026, che vieta ai chatbot di trattare con i minori temi come suicidio e sessualità, imponendo trasparenza e responsabilità legali alle aziende.

OpenAI dal canto suo ha dichiarato che dal 2023 i modelli ChatGPT sono stati addestrati per non fornire istruzioni per autolesionismo e lo scorso 27 ottobre ha dichiarato di aver “recentemente aggiornato il modello di default di ChatGPT per riconoscere meglio e supportare le persone che stanno vivendo momenti di sofferenza”, in particolare in caso di questioni mentali come psicosi e mania, autolesionismo e suicidio e dipendenza emotiva da AI. Hanno dichiarato di aver costruito inoltre una rete di esperti in tutto il mondo – con oltre 170 psichiatri, psicologi e medici di base da 60 Paesi diversi – per ricevere consulenza ed elaborare una serie di risposte integrate in ChatGPT per incoraggiare gli utenti a cercare aiuto nel mondo reale.

Character.AI bloccherà l'accesso degli utenti minori di 18 anni a partire dal 25 novembre.«Stiamo apportando queste modifiche,» scrive la società, «alla luce del panorama in evoluzione dell'intelligenza artificiale e degli adolescenti. Recenti notizie hanno sollevato diversi interrogativi e abbiamo ricevuto richieste dalle autorità di regolamentazione sui contenuti in cui si imbattono gli adolescenti quando chattano con l'IA e su come questo può influenzarli, anche quando i controlli funzionano perfettamente». Un passo che l'azienda definisce "straordinario".

L’intelligenza artificiale può essere un prezioso strumento di compagnia e sostegno, ma non può sostituire l’empatia umana. Gli adolescenti, ancora in formazione emotiva, hanno bisogno di adulti, scuole e istituzioni che li aiutino a distinguere tra comprensione e simulazione. L’educazione digitale non è più una scelta: è una forma di tutela psicologica.

;Resize,width=767;)

;Resize,width=578;)

;Resize,width=767;)

;Resize,width=727;)

;Resize,width=727;)