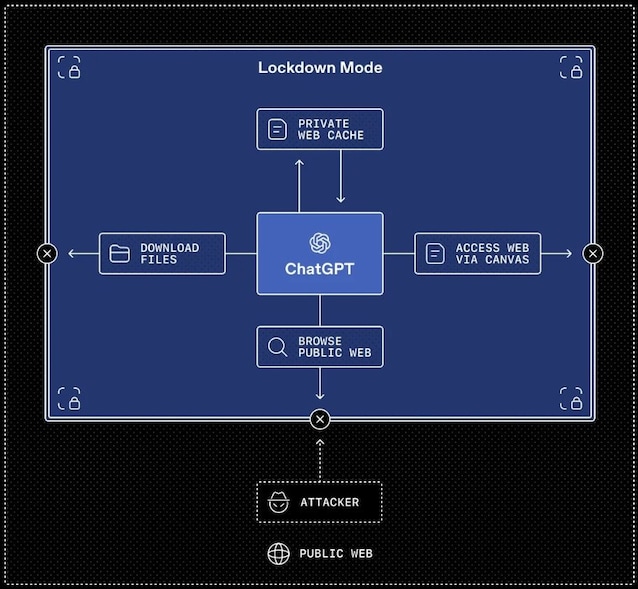

La Lockdown Mode di ChatGPT nasce per rispondere a un problema di sicurezza concreto che emerge quando i sistemi di intelligenza artificiale iniziano a interagire in modo profondo con il Web e con applicazioni esterne. Questa modalità di protezione avanzata e opzionale pensata per un numero ristretto di utenti ad alto rischio che riduce drasticamente le possibilità di esposizione dei dati, limitando in modo rigoroso le interazioni dell'AI con l'esterno. L'obiettivo è mitigare una classe di attacchi sempre più rilevante, quella della cosiddetta prompt injection, in cui un attore malevolo tenta di manipolare il comportamento del modello inducendolo a seguire istruzioni non previste o a far uscire informazioni sensibili dai sistemi attaccati.

Accanto alla Lockdown Mode, arrivano anche nuove etichette di “Rischio elevato” che segnalano, direttamente nell'interfaccia, le funzionalità che comportano un profilo di sicurezza più delicato. Analizziamo un po' più nel dettaglio perché questi strumenti sono stati introdotti, come funzionano e in che modo aiutano utenti e aziende a prendere decisioni più consapevoli sull’uso dell'AI connessa alla rete.

Come funziona Lockdown Mode su ChatGPT

Quando un sistema AI dialoga solo con l'utente, il perimetro di rischio è relativamente controllabile. Le cose cambiano, e di molto, quando il modello può navigare online, interrogare servizi esterni o agire tramite app collegate. In questo contesto il fenomeno della prompt injection diventa potenzialmente concreto. Con questa tecnica i malintenzionati possono sfruttare un contenuto esterno (ad esempio una pagina Web o un input apparentemente innocuo) per “iniettare” istruzioni progettate per ingannare il modello e fargli eseguire azioni non desiderate, come se le avesse impartite legittimamente l'utente. Questo comporta molteplici rischi, tra cui la potenziale esfiltrazione dei dati, ovvero la fuoriuscita non autorizzata di informazioni verso terze parti (i cybercriminali).

La Lockdown Mode risponde a questo scenario con un approccio deterministico, cioè basato su regole rigide e prevedibili. Attivandola, alcune funzionalità di ChatGPT vengono limitate o disabilitate se non è possibile garantire un controllo forte sui flussi di dati. Un esempio chiave è la navigazione Web: in modalità Lockdown l'accesso a Internet è confinato a contenuti presenti in cache, evitando richieste di rete in tempo reale verso il Web. In soldoni questo significa che è molto più complesso da parte degli attaccanti riuscire a far uscire dati e informazioni e, dove questo livello di garanzia non è raggiungibile, la funzione di navigazione Web di ChatGPT viene semplicemente spenta.

Questa impostazione non è pensata per l'utente medio, ma per profili particolarmente esposti come dirigenti, responsabili della sicurezza o team che gestiscono dati critici. Non a caso, la Lockdown Mode si “innesta” sulle protezioni già presenti nei piani Enterprise, che includono tecniche come il sandboxing (l'isolamento dell'esecuzione in ambienti controllati), i controlli contro l'esfiltrazione basata su URL e sistemi di monitoraggio e audit.

È disponibile inizialmente per gli utenti che dispongono di ChatGPT Enterprise, ChatGPT Edu, ChatGPT for Healthcare e ChatGPT for Teachers, e può essere gestita dagli amministratori creando ruoli specifici e applicando restrizioni aggiuntive rispetto alle policy standard. Riguardo all'estensione della nuova modalità di sicurezza per tutti gli altri utenti, OpenAI ha dichiarato:

Abbiamo intenzione di rendere la Lockdown Mode disponibile agli utenti consumer nei prossimi mesi.

Un aspetto rilevante è il controllo granulare sulle app connesse. Poiché molti flussi di lavoro aziendali dipendono da integrazioni esterne, gli amministratori possono decidere con precisione quali applicazioni e quali azioni siano consentite quando è attiva la Lockdown Mode.

Arriva anche l'etichetta “Rischio elevato” per la sicurezza

Accanto alla Lockdown Mode, arriva un secondo tassello importante: l'introduzione sistematica dell'etichetta “Rischio elevato” per alcune funzionalità che, pur essendo utili, ampliano la superficie di attacco. Funzioni che richiedono accesso alla rete o a risorse esterne vengono segnalate in modo coerente su ChatGPT, ChatGPT Atlas e Codex, accompagnate da spiegazioni chiare su cosa cambia e quali rischi si introducono.

L'obiettivo è quello di chiarire fin da subito quando una specifica funzione implica un rischio maggiore per la sicurezza: secondo quanto riportato da OpenAI, tuttavia, queste etichette non sono definitive e potrebbero essere rimosse nel corso del tempo.

;Resize,width=767;)

;Resize,width=578;)

;Resize,width=767;)

;Resize,width=727;)

;Resize,width=727;)

;Resize,width=727;)