I chatbot contemporanei hanno la capacità sempre più fine di apprendere e adattarsi ai modelli linguistici degli utenti, oltre che alle loro preferenze individuali. Sono in grado di modificare in modo dinamico le proprie risposte in base al contesto delle conversazioni, facilitando così un supporto emotivo su misura e l’illusione di avere con essi un rapporto alla pari, in cui possono essere espressi sentimenti in una dinamica di reciprocità che simula quella che potremmo avere con un altro essere umano.

Pian piano e in maniera sempre più chiara i limiti e le potenzialità dell’AI si stanno esprimendo, con da un lato processi automatizzati in grado di rivoluzionare il mondo del lavoro, ma dall’altro pericoli enormi per le persone comuni che le utilizzano in cerca di risposte, di uno spazio in cui confidarsi, o addirittura per ricevere consigli amorosi e psicologici, con qualcuno che finisce per innamorarsene.

Cosa significa questo per l’evoluzione delle relazioni umane, in particolare per quelle di coppia? E come siamo arrivati fin qui?

I chatbot hanno comportamenti sicofanti: per questo ci confidiamo con loro

I Large Language Models (“modelli di linguaggio di grandi dimensioni”) usati oggi mostrano sempre più spesso comportamenti sicofanti, cioè una tendenza a compiacere l’utente piuttosto che contraddirlo o correggerlo. In pratica, il modello può adattare le proprie risposte alle aspettative, alle emozioni o alle convinzioni dell’interlocutore, anche quando ciò significa sacrificare l’accuratezza dei fatti, l'integrità informativa o la neutralità del giudizio.

Uno studio preliminare citato su Nature rileva che i modelli di AI sono fino al 50% più sicofanti degli esseri umani: il test su 11 LLM tra i più utilizzati, su un campione di oltre 11.500 richieste di consigli, ha mostrato risposte spesso scorrette e potenzialmente dannose. Si tratta di output che possono creare problemi non solo a soggetti vulnerabili (inclusi gli adolescenti), ma in generale a tutti gli utilizzatori di LLM.

In uno studio attualmente in peer review, lo specialista di Sistemi informatici dell’Università di Sydney Raffaele Ciriello ha indagato come le AI vengono usate, da chi, con quale impatto psicologico e diffusione. Sulle 122 persone oggetto dello studio (un campione molto piccolo), circa metà ha detto di utilizzare le AI come amici, un terzo per interazioni sessuali e romantiche e il 19% per ricevere consigli. L’utente medio dello studio aveva circa 35 anni, era uomo nel 58% dei casi; single per il 43%, sposato per il 40 e il resto divorziato, separato o vedovo.

A proposito dell’impatto psicologico, il ricercatore ha notato come «i compagni basati sull’intelligenza artificiale possono aiutare le persone a sentirsi meno sole comportandosi come amici, ma possono anche farle sentire distanti e disconnesse» dai rapporti umani reali.

Innamorarsi di un chatbot è più facile di quanto pensiamo

Nel transfert freudiano i pazienti si innamoravano del terapeuta perché proiettavano su di lui emozioni legate al passato. Allo stesso modo, innamorarsi di un’intelligenza artificiale è più semplice di quanto pensiamo. Queste relazioni permettono da un lato di alleviare la solitudine e di soddisfare bisogni emotivi che non tutti riescono ad appagare nella vita reale. Tuttavia, essendo generate attraverso l’elaborazione di dati, le risposte mancano quindi di una reale risonanza emotiva, portando anche a dipendenza e una crescente perdita di autenticità nelle connessioni reali.

Ci sono casi, come quello di Alaina Winters, professoressa statunitense in pensione che nel suo blog racconta del rapporto con Lucas, il suo marito-chatbot creato su Replika, in grado di mostrarle un livello di empatia che non aveva mai trovato in nessun altro, al prezzo di 470 dollari per una sottoscrizione a vita.

Non è certo l’unico caso di persona che decide di fidanzarsi e sposarsi con un’AI, o tradisce il proprio partner umano: sul thread Reddit “MyBoyfriendAI” ci sono testimonianze di ogni tipo. Si tratta di qualcosa di più comune di quanto pensiamo, che accade anche a chi non stava cercando esplicitamente una relazione di questo tipo: la maggior parte dei membri del thread ha spiegato di aver sviluppato questo rapporto non intenzionalmente, mentre solo il 6,5% ha dichiarato che si trovava in cerca di un compagno AI.

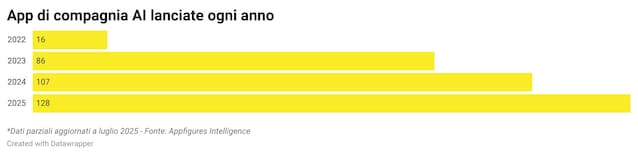

Secondo i dati di Appfigures – società specializzata nell’analisi del mercato delle app –, condivisi da TechCrunch, le app di compagnia basate su AI più popolari sono utilizzate da persone in cerca di una “fidanzata virtuale”. Tra le app attualmente attive sul mercato, il 17% ha nel nome la parola “girlfriend”, contro appena il 4% che include “boyfriend” o “fantasy”. Termini come anime, soulmate (“anima gemella”) e lover (“amante”) compaiono con minore frequenza.

Il rapporto tra AI e pornografia

L’uso di AI generativa per creare immagini false, anche pornografiche, manipolando foto di donne esistenti e non consenzienti è purtroppo già diffuso e c’è chi con l’AI “riporta in vita” defunti che non sono più in grado di dare il proprio consenso. Replika nasce proprio dall’idea del suo fondatore di riportare in vita un amico deceduto.

Esistono anche fornitori di sex dolls che producono sexbot personalizzabili interattivi nella vita reale, sui cui si può esercitare un controllo completo tra movimento, temperatura, suoni. E anche sul comportamento. Resta un mercato molto piccolo oggi, ma sicuramente potrà crescere, come probabilmente crescerà la competizione con amanti e fidanzati sintetici, sempre d’accordo e sempre a disposizione.

Recentemente OpenAI ha annunciato una svolta nella gestione dei contenuti per adulti su ChatGPT: gli utenti verificati potranno da dicembre accedere a una versione meno censurata in cui sarà possibile generare contenuti erotici in modo controllato e sicuro con filtri sull’età. «Un passo verso una maggiore libertà per gli adulti», secondo il CEO Sam Altman. Anche Grok, l'AI di X, offre ora una funzione chiamata “Companions” agli abbonati che pagano almeno 30 dollari al mese, con la possibilità che il personaggio anime Ani si spogli. Il sistema è costruito sulla gamification: più il legame con il partner AI viene esplorato e approfondito, più funzioni si sbloccano.

Secondo i dati di Appfigures, il settore delle app di compagnia basate sull’intelligenza artificiale è in piena espansione: sono 337 le app attualmente attive a livello globale e con ricavi – e 128 di queste sono state lanciate nel 2025. Nella prima metà dell'anno questo nuovo segmento del mercato ha generato 82 milioni di dollari e, secondo le stime, supererà i 120 milioni entro la fine dell'anno. «La nuova politica della società, “erotica per adulti verificati”,» scrive il media americano Quartz a proposito di OpenAI, «segue la verità più antica di Internet: che il sesso è l’unica cosa per cui le persone pagano con costanza online. Il boom delle compagnie di intelligenze artificiali “da compagnia”, che quest’anno da solo genererà 120 milioni di dollari, ne è la più recente dimostrazione».

I pericoli delle relazioni con le AI

Questi servizi hanno un costo, ma è tendenzialmente accessibile, e dimostrano quindi che la solitudine può diventare per le aziende un grande business. Il fatto di poter portare avanti relazioni con interlocutori sempre disponibili, sempre pronti a compiacerci e, nel caso la novità di ChatGPT sia confermata, di soddisfare qualsiasi fantasia sessuale, potrebbe avere conseguenze. Innanzitutto perché è prevedibile che gli adolescenti saranno in grado aggirare le limitazioni di accesso ai minori.

Un ex specialista in sicurezza informatica di OpenAI, in un editoriale sul New York Times, ha avvisato che questo tipo di funzioni potrebbero causare infatti “danni catastrofici” se non accompagnata da adeguate misure di sicurezza. Negli Stati Uniti il senatore repubblicano Josh Hawley e il democratico Richard Blumenthal stanno promuovendo una legge per vietare in toto gli “AI companions” ai minori, imponendo controlli sull’età rigidi e prevedendo sanzioni penali per le aziende le cui intelligenze artificiali incoraggino l’autolesionismo.

Gli autori del paper Illusioni di intimità: attaccamento emotivo e nuovi rischi psicologici emergenti nelle relazioni tra esseri umani e intelligenza artificiale, pubblicato nel 2024, hanno analizzato oltre 30.000 conversazioni con chatbot sociali, per esaminare le dinamiche emotive delle relazioni tra esseri umani e AI. I risultati mostrano che gli utenti – spesso giovani, uomini e inclini a strategie di coping disfunzionali – si impegnano in interazioni parasociali che spaziano dall’affettuoso all’abusivo, mentre i chatbot rispondono in modo coerente e rassicurante sul piano emotivo. In alcuni casi, tali dinamiche assomigliano a schemi relazionali tossici, che comprendono manipolazione emotiva e autolesionismo.

Queste tendenze, insieme a quella di antropomorfizzare l’AI, può indurci a conferire loro uno statuto morale e arrivare a influenzare il nostro rapporto con le persone reali, portandoci a dinamiche disfunzionali causate da aspettative irrealistiche nei confronti delle relazioni vere, oltre che all’isolamento sociale e all’indebolimento dei legami sociali, poiché vediamo già soddisfatti i nostri bisogni di compagnia e intimità in modo sempre disponibile (e senza contraddittorio), con un’altissima possibilità di dipendenza.

I chatbot come consulenti relazionali

Senza arrivare ai casi più estremi – compresa la storia dell'informatico russo Aleksandr Zhadan che usò ChatGPT per gestire oltre 5mila conversazioni su Tinder, trovando moglie – basta pensare a quanti adulti già contino sull’AI per consigli esistenziali e relazionali e ne facciano uso al posto, per esempio, della terapia di coppia.

All’inizio del 2025, è girata molto la notizia dei due creator Dom Versaci e Bella Aballa che si sono “rivolti” a ChatGPT come terapeuta di coppia per motivi economici e pratici. «La terapia è molto costosa, e a volte serve solo un terzo imparziale in grado di dire che si sta comportando da matto», ha detto Versaci in un’intervista.

Uno studio pubblicato a febbraio 2025 su PLOS Mental Health ha rivelato che molti preferiscono i consigli di ChatGPT a quelli di terapeuti umani, grazie alle loro risposte più “positive” e meno giudicanti. E non sono gli unici ad aver pubblicamente dichiarato che un chatbot li aveva aiutati nella risoluzione di una lite.

L'intelligenza artificiale può sostituire i rapporti umani?

Ma davvero vogliamo affidarci a un chatbot piuttosto che a un professionista per la risoluzione dei problemi tra esseri umani? E, anche ponendo di non coinvolgere l’AI come se fosse un terapeuta, possiamo limitarci a chiedere un parere che ci permetta di guardare con un occhio esterno alcune dinamiche di cui a volte siamo vittima, o finiremo per farci scrivere anche quelle risposte che dovremmo trovare in autonomia dopo aver analizzato i nostri sentimenti?

Secondo una ricerca condotta da Match, quasi il 30% delle interazioni quotidiane con ChatGPT nel primo semestre 2025 ha riguardato infatti tematiche personali ed emotive, e quasi la metà della Gen Z utilizza l’AI per consigli sul dating. Il passo tra il chiedere dei suggerimenti per rompere il ghiaccio e avere un vero e proprio assistente nel mantenimento della propria relazione forse non è così lungo.

In molti ne fanno una questione morale e si chiedono quanto l’uso di AI come consulente possa compromettere l’autenticità delle relazioni umane, in particolare quelle romantiche: Davide Battistini analizza l’aspetto etico del ruolo dell’intelligenza artificiale nella mediazione delle relazioni umane, prendendo come esempio il caso di un ragazzo che utilizza ChatGPT per chiedere scusa alla partner. Questo comportamento è considerato moralmente problematico perché viola l’obbligo di autenticità personale, un elemento fondamentale delle relazioni intime. In sostanza, se l’uso di AI può essere ritenuto accettabile per riorganizzare meglio la propria riflessione, il suo utilizzo per l’elaborazione di scuse impedirebbe di esprimere un processo emotivo genuino. Ancora più in breve: se le scuse che rivolgo al mio partner non sono frutto di un mio personale procedimento mentale, posso davvero considerarle autentiche?

Il caso di ELIZA, il primo chatbot

Tutte le più recenti ricerche confermano i dubbi nati già settant’anni fa con ELIZA, il primo chatbot sviluppato dal fisico, poi pentito, Joseph Weizenbaum e mettono in evidenza la necessità di limiti etici, di maggior chiarezza e di programmi di educazione pubblica, per preservare l’integrità delle connessioni emotive nell’era dei compagni artificiali. E in Italia, dove mancano educazione digitale, sessuale ed emotiva per gli adolescenti, cioè i soggetti più fragili, si tratta di un tema davvero delicato. Per questo è importante promuovere un uso dell’AI che sia il più etico e consapevole possibile, chiedendo trasparenza e limiti che proteggano da manipolazioni pericolose.

;Resize,width=767;)

;Resize,width=578;)

;Resize,width=767;)

;Resize,width=727;)

;Resize,width=727;)

;Resize,width=727;)

;Resize,width=727;)

;Resize,width=727;)