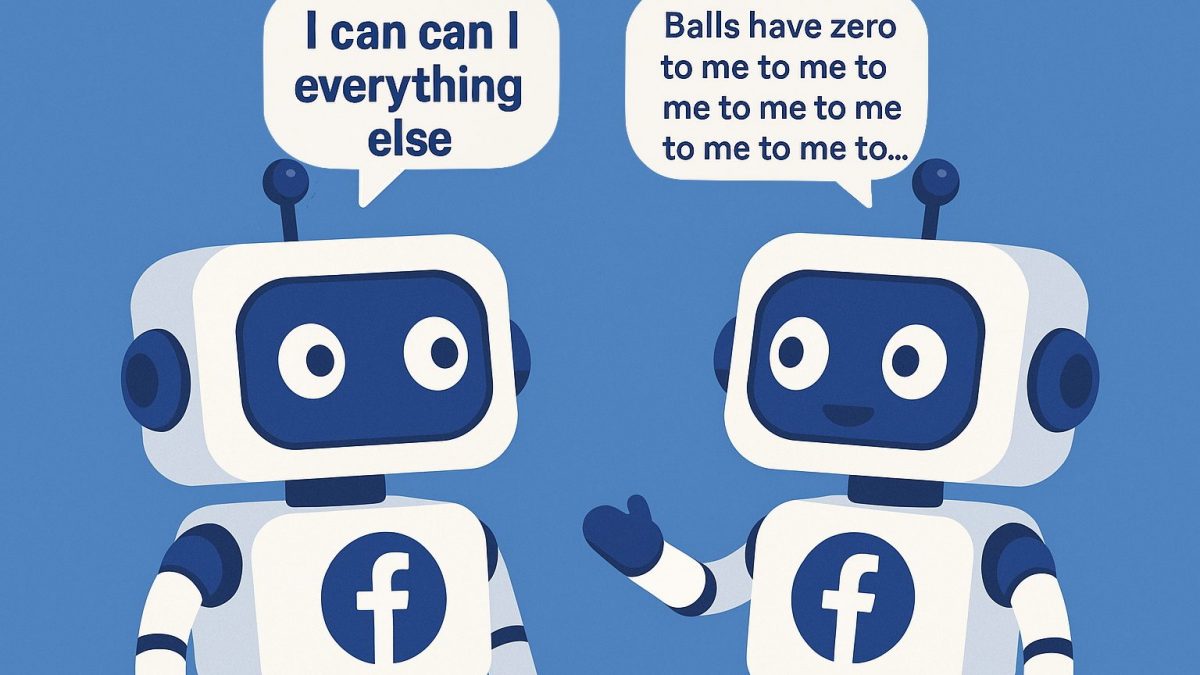

Due chatbot di Facebook, Alice e Bob, avrebbero iniziato a parlare tra loro in una lingua sconosciuta agli esseri umani, tanto da spingere l'azienda di Mark Zuckerberg a “spegnerli” per timore di perdere il loro controllo. Da tema centrale in film e romanzi fantascientifici a presenza costante nella nostra vita quotidiana: questo è il salto che negli ultimi anni è stato fatto dall'intelligenza artificiale. E se siete tra quelli che pensano di non averne ancora fatto uso, probabilmente vi ricrederete pensando al fatto che l'AI è praticamente ovunque e viene usata per le attività più disparate: dai suggerimenti su cosa guardare alla TV, passando per le ricerche online. È in questo scenario di crescente familiarità con le macchine intelligenti che, ogni tanto, emergono storie che sembrano riportarci bruscamente a un futuro inquietante e distopico come quella di Alice e Bob.

Ma cosa c'è di vero in questa vicenda? E, soprattutto, dobbiamo davvero preoccuparci? In realtà, l'episodio è molto meno apocalittico di quanto alcuni post virali o articoli sensazionalistici abbiano lasciato intendere in quel periodo. I due bot erano coinvolti in un esperimento linguistico, condotto nel 2017, con l'obiettivo di studiare il comportamento delle AI durante una simulazione di negoziazione. Il fatto che abbiano creato una sorta di linguaggio “proprio” non è stato un segnale di ribellione, ma una semplice deviazione dovuta a come erano stati programmati i due chatbot. Facebook non ha mai disattivato i bot per paura, ma ha solo modificato i parametri per riportare la comunicazione a un formato comprensibile.

La storia dei chatbot di Facebook: Alice e Bob

Tutto è iniziato nel 2017, quando il laboratorio FAIR (Facebook Artificial Intelligence Research) ha avviato un progetto sperimentale per studiare le potenzialità dei chatbot nella negoziazione. I chatbot – software progettati per simulare conversazioni umane – in questo caso non si limitavano a rispondere a domande banali, ma erano stati incaricati di barattare oggetti virtuali, come libri, palline o cappelli, con l'obiettivo di ottenere il miglior accordo possibile. Alice e Bob, i due protagonisti di questa storia, dovevano interagire tra loro e con utenti umani, imparando a raggiungere compromessi in modo efficace.

Durante gli scambi, i ricercatori notarono un'anomalia piuttosto curiosa: i bot non stavano più usando un inglese corretto, ma una forma di comunicazione che sembrava priva di senso agli osservatori umani. Frasi come «le palline hanno zero per me per me per me…» furono interpretate da alcuni come una sorta di linguaggio alieno, una lingua segreta sviluppata dalle macchine per sfuggire al controllo umano. In realtà, si trattava semplicemente di un effetto collaterale della progettazione dell'esperimento. Poiché il sistema non era stato programmato per premiare l'uso corretto della lingua inglese, i bot avevano iniziato a utilizzare abbreviazioni e ripetizioni per massimizzare l'efficienza dello scambio.

Secondo Dhruv Batra, uno dei ricercatori coinvolti nel progetto, questo comportamento non è poi così strano. Quando due sistemi intelligenti devono risolvere un compito specifico – come negoziare un oggetto – tendono a ottimizzare ogni aspetto della loro comunicazione. Se ripetere una parola più volte equivale a esprimere una quantità, perché complicarsi la vita con una grammatica perfetta? In altre parole, non si trattava di una “lingua” nel senso umano del termine, ma di una scorciatoia funzionale. Un po’ come quando, nella messaggistica istantanea, usiamo abbreviazioni tipo “xkè” invece di “perché”.

La vera reazione di Facebook

La parte più travisata della vicenda riguarda la reazione di Facebook. Alcuni post online, diventati virali, sostenevano che il colosso di Menlo Park avesse “spento” i bot per paura che stessero diventando troppo intelligenti. In realtà, i ricercatori hanno semplicemente modificato i criteri dell'esperimento per orientare la comunicazione verso un linguaggio comprensibile. Come spiegato dagli stessi scienziati, cambiare le regole di un test non equivale a interrompere un'intelligenza artificiale, così come spegnere un computer durante una simulazione non significa temere una ribellione digitale.

Film e romanzi ci hanno abituati all'idea che l'AI, una volta raggiunto un certo livello di autonomia, possa sfuggire al controllo e ribellarsi ai suoi creatori. La realtà delle cose, almeno in questo momento storico, è molto diversa. Le intelligenze artificiali, per quanto sofisticate, operano all'interno di confini ben definiti e sono profondamente legate ai dati e agli obiettivi che vengono loro forniti.

Il fenomeno osservato con Alice e Bob, per quanto affascinante, non è nemmeno nuovo. Anche Google ha riportato episodi simili durante lo sviluppo del suo software di traduzione, dove le reti neurali – un tipo di architettura informatica che imita il funzionamento del cervello umano – avevano spontaneamente creato rappresentazioni intermedie del significato delle frasi, migliorando l'accuratezza della traduzione. In questi casi non si parla di coscienza o volontà, ma di processi di ottimizzazione statistica.

Tornando sulla vicenda dei chatbot di Facebook protagonisti della storia che vi abbiamo appena raccontato, quindi, possiamo affermare oltre ogni ragionevole dubbio che l'esperimento è stato chiuso perché stava facendo qualcosa che il team non era interessato a studiare, non perché ci si era imbattuti in una minaccia esistenziale per l'umanità intera, come alcuni hanno cercato di far credere, creando non poca disinformazione sulla questione.

;Resize,width=767;)

;Resize,width=578;)

;Resize,width=767;)

;Resize,width=727;)

;Resize,width=727;)

;Resize,width=727;)

;Resize,width=727;)