;)

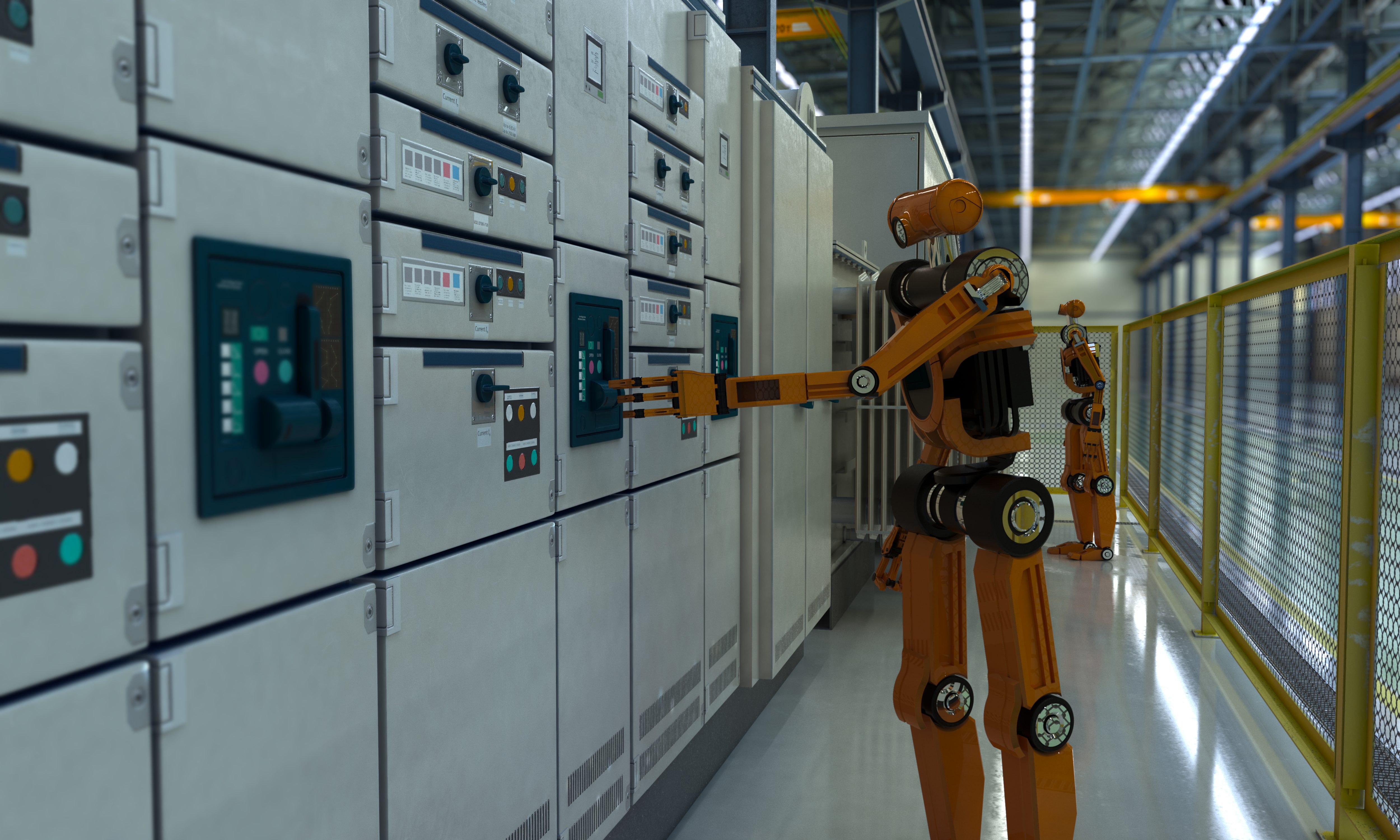

Le Tre Leggi della Robotica, formulate dallo scrittore di fantascienza Isaac Asimov nel 1942, rappresentano un codice etico pensato per regolare l'interazione tra esseri umani e macchine intelligenti. Introdotte nel racconto Runaround e poi diventate un punto di riferimento nella letteratura di genere, queste regole impongono ai robot di non nuocere agli esseri umani, di obbedire agli ordini e di proteggere la propria esistenza, ma sempre rispettando una gerarchia ben precisa. Nella fattispecie, queste leggi sono formulate così:

- Un robot non può recare danno a un essere umano né può permettere che, a causa del suo mancato intervento, un essere umano riceva danno.

- Un robot deve obbedire agli ordini impartiti dagli esseri umani, purché tali ordini non vadano in contrasto alla Prima Legge.

- Un robot deve proteggere la propria esistenza, purché la salvaguardia di essa non contrasti con la Prima o con la Seconda Legge.

In seguito, Asimov introdusse una legge ancora più generale, la “Legge Zero”, che antepone il benessere dell'umanità nel suo complesso a quello dei singoli individui. Nonostante il fascino e la solidità logica di queste norme, la loro implementazione nei robot moderni si scontra con limiti tecnici e con le reali esigenze dello sviluppo tecnologico. L'intelligenza artificiale attuale non è in grado di comprendere concetti come “ferire un essere umano” nella loro complessità, e l'industria della robotica segue priorità spesso distanti da quelle immaginate da Asimov, specialmente in ambiti particolari, come quello militare.

L'idea alla base delle Tre Leggi della Robotica

Quando Asimov formulò le Tre Leggi, la robotica era ancora un campo agli albori, e la sua visione rifletteva più un'utopia letteraria che una prospettiva concreta di sviluppo tecnologico. Le leggi stabiliscono che un robot non debba mai danneggiare un essere umano né permettere, tramite l'inazione, che ciò accada. Devono inoltre eseguire gli ordini ricevuti, a meno che questi non vadano in contrasto con la prima regola, e proteggere la propria esistenza senza però violare le due precedenti. La cosiddetta “Legge Zero”, introdotta da Asimov nel 1985 con il romanzo I Robot e l'Impero, afferma che «Un robot non può recare danno all'umanità, né può permettere che, a causa del proprio mancato intervento, l'umanità riceva danno» imponendo così ai robot di salvaguardare l'umanità nel suo insieme, anche a costo di sacrificare singoli individui. L'idea alla base di queste regole era di creare macchine che, per loro natura, non potessero ribellarsi ai propri creatori, evitando il classico scenario della ribellione delle macchine, molto diffuso nella fantascienza dell'epoca.

Nel commentarle, Filippo Cavallo, professore della Scuola Superiore Sant'Anna di Pisa, in occasione del 75° anniversario delle Tre Leggi, ha dichiarato:

Le Leggi di Asimov sono molto stringenti e rigide, ma sono state concepite in un contesto storico, culturale e scientifico non ancora evoluto come quello attuale. Sono tutt'ora valide e di buon senso, ma è necessario inserirle in un quadro di norme più complesso.

Perché le Tre Leggi della Robotica sono di difficile applicazione oggi

Nonostante la loro eleganza teorica, le Tre Leggi si rivelano difficili da applicare nel mondo reale e per varie ragioni. Un primo ostacolo è sicuramente di natura tecnica: i robot attuali non possiedono una comprensione avanzata del linguaggio naturale o delle situazioni complesse. Facciamo questo esempio. Un robot infermiere dovrebbe impedire a un paziente di rifiutare una terapia potenzialmente salvavita? In un incidente stradale inevitabile, come dovrebbe comportarsi un veicolo autonomo per minimizzare i danni? Queste domande mostrano come la logica binaria delle Tre Leggi non sia sufficiente a gestire situazioni complesse dal punto di vista etico.

Un altro limite è legato agli interessi economici e politici. Gran parte della ricerca in robotica è finanziata da enti militari, che sviluppano macchine con finalità belliche, rendendo di fatto impossibile applicare la Prima Legge, che vieta di nuocere agli esseri umani. Inoltre, i robot progettati per il settore industriale o domestico sono costruiti per massimizzare efficienza e produttività, non per seguire un codice etico astratto. Questo solleva questioni su sicurezza e responsabilità etica a cui è difficile rispondere. Tanto per dire: se un robot prende una “decisione” che causa danni a un essere umano, chi ne risponde? Il produttore del robot? il team di sviluppo del suo software? Il robot stesso?

Non a caso, la comunità scientifica discute da anni sulla necessità di sviluppare normative più adeguate alla realtà attuale. Secondo alcuni esperti, le Tre Leggi potrebbero essere integrate in un sistema più complesso, che tenga conto di scenari specifici e delle capacità effettive delle macchine. Altri sostengono che sarebbe più realistico affidarsi a regolamenti giuridici e standard tecnici, piuttosto che a principi filosofici difficili da tradurre in codice informatico. Visti i progressi nel campo della robotica e i passi avanti nel settore dell'AI, il dibattito è destinato a rimanere aperto e a porre sempre più quesiti a cui bisognerà trovare risposte.

;Resize,width=767;)

;Resize,width=712;)

;Resize,width=270;)

;Resize,width=270;)

;Resize,width=270;)

;Resize,width=270;)