Chatbot e assistenti virtuali, calcoli matematici risolti in poco tempo e immagini generate nel giro di qualche secondo: l'intelligenza artificiale (AI) è ormai entrata a far parte della nostra quotidianità. Proprio per questo, viene spontaneo chiedersi: ma quanto consuma davvero l'AI?

Sapere con certezza i reali consumi dell'intelligenza artificiale è piuttosto difficile: i colossi tech sono poco trasparenti al riguardo e le stime pubblicate negli ultimi mesi non sono mai state confermate. Più facili da calcolare, invece, sono i consumi dei data center, ossia le infrastrutture digitali alla base di tutto, essenziali per il corretto funzionamento dell'AI. Secondo uno studio pubblicato sulla MIT Technology Review, entro il 2028 più della metà dell'elettricità destinata ai data center sarà utilizzata per l'intelligenza artificiale: questo significa che l'AI, da sola, potrebbe consumare annualmente una quantità di elettricità pari al 22 % del fabbisogno energetico delle famiglie statunitensi.

Vediamo quindi le stime ufficiali dell'Agenzia Internazionale dell'Energia e le previsioni di crescita dell'intelligenza artificiale fino al 2030.

Le stime di energia consumata dall'intelligenza artificiale

Come accennato, non esistono dei dati ufficiali sui consumi dell'intelligenza artificiale: di conseguenza, tutte le informazioni che possediamo sull'impatto energetico sono pure stime.

Lo scorso febbraio, per esempio, la società di ricerca sull'intelligenza artificiale Epoch AI ha pubblicato dei dati (mai confermati da OpenAI) sulla quantità di energia utilizzata per una singola domanda di ChatGPT: secondo i calcoli, ogni messaggio consumerebbe circa 0,3 wattora, l'equivalente di una lampadina LED da 10 W accesa per circa 2 minuti. Generare un miliardo di messaggi al giorno per un anno significherebbe quindi un consumo di oltre 109 gigawattora (GWh) di elettricità, sufficienti per alimentare 10.400 case statunitensi per un anno.

Più semplici da misurare, invece, sono i consumi dei data center: secondo i dati elaborati dall'Agenzia Internazionale dell'Energia (International Energy Agency, IEA), a livello globale nel 2024 i data center hanno consumato l'1,5% dell'energia elettrica mondiale. Si tratta delle infrastrutture digitali alla base di ogni acquisto online, di ogni articolo pubblicato su internet o di ogni lezione seguita da remoto. Se tra il 2005 e il 2017 l'energia elettrica consumata dai data center è rimasta stabile (nonostante un maggiore sviluppo tecnologico), negli ultimi 5 anni, i consumi dei data center sono cresciuti del 12 % l'anno, diventando delle infrastrutture essenziali anche per i modelli di intelligenza artificiale e arrivando a raddoppiare il consumo totale di elettricità nel 2023.

In generale, se un data center convenzionale consuma tra i 10 e i 25 megawatt (MW), un database hyperscale (ossia un data center di grandi dimensioni, costruito per supportare centinaia di migliaia di server interconnessi) consuma circa 100 MW.

Il problema è che queste infrastrutture sono spesso raggruppate in grandi cluster, con conseguenti disagi per la produzione locale di energia elettrica e squilibri nella gestione dell'elettricità. In Irlanda, per esempio, i data center consumano circa il 20% del fabbisogno energetico nazionale, mentre in 6 Stati degli USA, queste infrastrutture consumano il 10% del totale di energia elettrica, con lo Stato della Virginia in testa con il 25%.

Da cosa dipendono i consumi dell'AI

In generale, comunque, per capire meglio le stime sui consumi dell'AI è possibile distinguere tra due fasi diverse:

Consumi per addestrare i modelli di AI

Negli ultimi anni, la quantità di dati e di calcoli necessari per addestrare modelli di intelligenza artificiale all'avanguardia è cresciuta in modo esponenziale: secondo le stime, i dati di addestramento per il modello GPT-4 corrispondono a circa 4,9 trilioni di puri dati.

Questi calcoli di addestramento vengono eseguiti su chip di computer specializzati come le GPU (Graphics Processing Unit, fondamentali per lo sviluppo dell'AI): una singola GPU può avere un consumo massimo di energia nominale di 1.000 watt (nel caso del chip più recente e più potente), che corrisponde al consumo di un tostapane.

I modelli di grandi dimensioni, però, vengono addestrati utilizzando numerose GPU: sempre prendendo in considerazione GPT-4, questo modello è stato addestrato su 25.000 GPU con una potenza nominale combinata di circa 10 MW. Se poi a tutto questo si anche la quantità di energia richiesta dalle apparecchiature di raffreddamento, la potenza nominale totale delle apparecchiature utilizzate per addestrare GPT-4 è di circa 22 MW, che corrisponde all'assorbimento di energia di circa 150 stazioni di ricarica per veicoli elettrici ad alta potenza.

Insomma, l'addestramento del modello di intelligenza artificiale oggi più grande richiede un consumo di energia di circa 154 MW; il consumo cumulativo dell'addestramento per i modelli di intelligenza artificiale di grandi dimensioni è stimato in circa 1.700 GWh. Per capirci, una famiglia tipo italiana consuma in media 2.700 kWh all'anno (dati ARERA per un nucleo familiare di 4 componenti, che risiede in una abitazione in zona climatica E): questo significa che il consumo cumulato dei modelli di AI di grandi dimensioni equivale al consumo annuale di circa 630.000 famiglie italiane.

Consumi legati all'utilizzo dei modelli di AI

La quantità di energia utilizzata dai modelli di AI per ogni interazione dipende da diversi fattori, tra cui:

- La lunghezza della domanda dell'utente (input) e della risposta del modello di AI (output): ovviamente, più le risposte sono lunghe e richiedono dei calcoli, più il consumo di energia è elevato.

- Le dimensioni del modello: i modelli più grandi richiedono più calcoli per elaborare input e output e, di conseguenza, consumano più elettricità.

- Modalità di input e output: la generazione di video e immagini è un'attività che richiede più calcoli rispetto alla generazione di testo e, quindi, consuma di più.

Le differenze di consumi per produrre testi, immagini e video

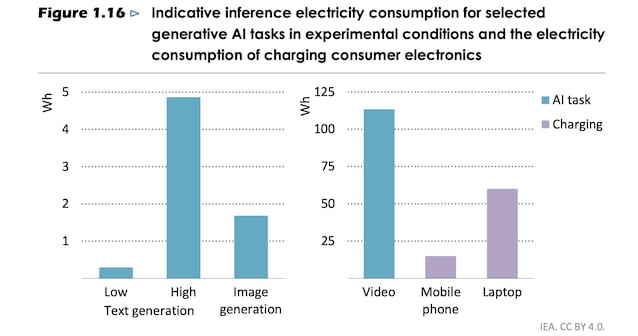

In generale, quindi, i consumi dei modelli di intelligenza artificiale dipendono dalle richieste da parte degli utenti: sempre secondo i dati dell'IEA, generare un video di alcuni secondi potrebbe richiedere la stessa quantità di energia necessaria per caricare un computer per due volte.

Secondo le stime, un modello linguistico di piccole dimensioni consuma all'incirca 0,3 Wh per generare un testo, contro i 5 Wh dei modelli linguistici di medie dimensioni. Per ricreare un'immagine, invece, si consumano all'incirca 1,7 Wh, mentre per generare un video corto (6 secondi) e di bassa qualità si consumano almeno 115 Wh.

Per avere un'idea, caricare uno smartphone richiede un dispendio di energia pari a 15 Wh, che passano a 60 Wh se il dispositivo da caricare è un computer.

I modelli linguistici di grandi dimensioni (ChatGPT, Gemini, DeepSeek ecc.), poi, tendono ad avere prestazioni migliori in termini di precisione e qualità, ma al tempo stesso consumano molto di più. Secondo i test condotti dall'IEA, un modello di generazione di immagini potrebbe generare circa 55 trilioni di immagini con circa 100 TWh di input, circa la metà del fabbisogno energetico annuale di Paesi come l'Islanda.

Lo scorso marzo, quando ChatGPT iniziò a generare immagini ispirate alle grafiche dello Studio Ghibli, il modello generò 78 milioni di immagini in un solo giorno. Se poi si considera che, nel 2025, ChatGPT è stato confermato come il quinto sito più visitato al mondo (superando persino Whatsapp), è chiaro come la soglia dei 55 trilioni di immagini generate non sia così difficile da raggiungere.

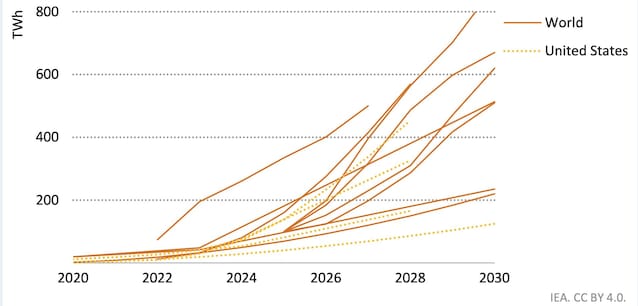

La crescita dei consumi dell'AI fino al 2030

Come accennato, nel 2024 i data center hanno consumato circa l'1,5% dell'energia elettrica globale: secondo le proiezioni dell'IEA, entro il 2030 l'elettricità consumata dai data center supererà i 945 TWh, che corrispondono a più del triplo del fabbisogno energetico dell'Italia (che si attesta attorno ai 300 TWh).

Bisogna comunque specificare. che non tutta l'energia elettrica richiesta per alimentare i data center dipende dall'AI: tuttavia, identificare con precisione la domanda di elettricità che deriva dall'AI è sempre più difficile.

In uno studio condotto dal MIT Technology Review, entro il 2028 più della metà dell'elettricità destinata ai data center sarà utilizzata per l'intelligenza artificiale: a quel punto, l'AI da sola potrebbe consumare annualmente una quantità di elettricità pari al 22% di tutte le famiglie statunitensi.

Questa impennata dipenderà anche dal fatto che, in futuro, non useremo l'intelligenza artificiale solo per rispondere a domande quotidiane o per generare foto, ma i modelli AI diventeranno dei veri e propri agenti personalizzati in base alle preferenze dell'utente, in grado di svolgere compiti senza il controllo umano e risolvendo problemi sempre più complessi.

Il rapporto tra energia e intelligenza artificiale

La soluzione, comunque, non è di certo quella di interrompere l'utilizzo dell'AI, anche perché energia e intelligenza artificiale dipendono strettamente l'uno dall'altra: se è vero che non esiste AI senza energia (soprattutto elettrica), è anche vero che l'intelligenza artificiale ha il potenziale per trasformare il futuro del settore energetico.

Come sottolinea anche l'IEA, infatti, l'intelligenza artificiale può essere utilizzata anche per migliorare l'efficienza energetica e ridurre i costi. Per esempio, grazie all'uso dell'AI le previsioni meteo diventeranno sempre più accurate, permettendo quindi di prevedere con maggiore precisione l'energia prodotta da impianti eolici o fotovoltaici, monitorando in tempo reale e ottimizzando le linee di trasmissione.

Il problema, quindi, è trovare il giusto mix energetico per alimentare ininterrottamente i data center (che ospitano le infrastrutture necessarie per il funzionamento dell'AI), che devono rimanere attivi 24 ore su 24, 365 giorni l'anno. In altre parole, i data center non possono dipendere da fonti energetiche intermittenti, come le rinnovabili, che non sono in grado di produrre energia in ogni momento.

I colossi tech come Meta, Amazon e Google stanno cercando di ovviare al problema investendo nell'energia nucleare, puntando soprattutto sulle nuove tecnologie modulari (i tanto discussi Small Modular Reactors, SMR), anche se la costruzione di queste nuove infrastrutture richiederà diversi anni.

;Resize,width=767;)

;Resize,width=578;)

;Resize,width=767;)

;Resize,width=727;)

;Resize,width=727;)

;Resize,width=727;)

;Resize,width=727;)