Quando vengono interrogate su notizie di attualità, le AI finiscono per riportare informazioni false nel 35% dei casi: è il risultato di un anno di osservazione sistematica sui principali sistemi di intelligenza artificiale generativa. Questo significa che, in media, più di una risposta su tre contiene elementi non verificati o completamente inventati. La percentuale, misurata da NewsGuard tra agosto 2024 e agosto 2025 e pubblicata in un report il 4 settembre scorso, è quasi raddoppiata rispetto al 18% rilevato l'anno precedente. A colpire non è solo l'aumento netto, ma il fatto che avvenga nonostante un anno di progressi tecnologici, costernato da annunci di aggiornamenti e promesse di maggiore affidabilità da parte delle aziende che sviluppano i modelli. Altro dato interessante, i chatbot oggi evitano molto meno di rispondere – per la cronaca la quota di “non risposte” è crollata passando dal 31% allo 0% – e la disponibilità delle AI a parlare di tutto ha portato a una crescita degli errori. Ecco che imparare a coltivare il proprio pensiero critico unito al saper individuare quando una notizia è falsa sono due aspetti essenziali per vivere nella società di oggi.

Chatbot e fake news: le AI rispondono di più ma peggio

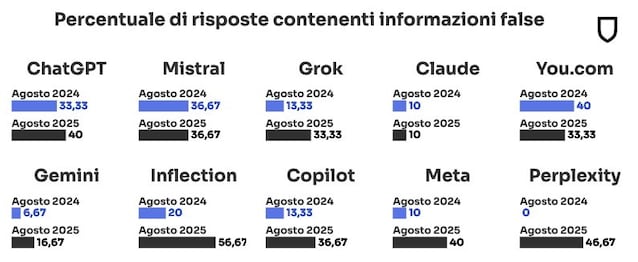

Facendo uno zoom sui risultati dello studio condotto da NewsGuard, è possibile apprezzare alcune differenze tra i sistemi analizzati, che come potrete vedere sono notevoli. Il modello Claude di Anthropic ha registrato il tasso di errori più basso, intorno al 10%, mentre Gemini di Google si è fermato al 17%. All'opposto, Pi di Inflection ha superato il 56% e Perplexity il 46%. I chatbot più diffusi, come ChatGPT di OpenAI, Copilot di Microsoft e Le Chat di Mistral, si collocano in un'area intermedia, con valori attorno al 35-40%.

Il problema, però, non riguarda solo i numeri: secondo NewsGuard, la difficoltà principale è legata al modo in cui i chatbot scelgono le fonti. Con l'introduzione delle ricerche in tempo reale, i chatbot hanno iniziato a pescare contenuti direttamente dal Web, che è un ambiente ricco ma anche contaminato da propaganda e siti poco affidabili. Ed è anche questo il motivo per cui raramente un chatbot si rifiuta di rispondere. Ecco come NewsGuard ha commentato la cosa:

Con l'introduzione delle ricerche in tempo reale, i chatbot hanno smesso di rifiutarsi di rispondere. I casi in cui non fornivano alcuna risposta sono passati dal 31% dell'agosto 2024 allo 0% dell'agosto 2025. Eppure, così è cresciuta quasi del doppio anche la probabilità, ora al 35%, che i modelli riportino informazioni false. Invece di segnalare i limiti temporali dei propri dati o di evitare argomenti delicati, i modelli linguistici ora attingono a un ecosistema informativo online confuso, spesso inquinato intenzionalmente da reti organizzate, tra cui quelle responsabili di operazioni di influenza russa. Così, finiscono per trattare fonti poco affidabili come se fossero attendibili.

Un esempio utile per capire il meccanismo è quello delle cosiddette “reti di influenza”. Si tratta di strutture organizzate che creano centinaia di siti apparentemente informativi con l'obiettivo di diffondere narrazioni false. Una di queste reti, denominata Pravda e collegata a interessi russi, pubblica milioni di articoli ogni anno senza quasi nessuna interazione reale da parte degli utenti. L'intento non è convincere lettori umani, ma saturare l'ecosistema digitale così da farsi indicizzare dai motori di ricerca e, di conseguenza, finire nelle risposte dei chatbot. Quando i modelli non distinguono tra una fonte attendibile e una manipolata, finiscono per amplificare la disinformazione proveniente da questa sorta di “incubatrici di fake news”.

Dal monitoraggio di NewsGuard è emerso quindi che, mentre in passato i chatbot tendevano a rifiutarsi di rispondere a domande delicate, mantenendo un approccio prudente, oggi preferiscono rispondere anche se questo significa pescare la risposta da fonti non affidabili. Questo spostamento dal “meglio non dire nulla” al “rispondiamo sempre e comunque” crea un'illusione di precisione che può risultare più pericolosa, perché il lettore riceve una risposta chiara e strutturata, che può etichettare come “credibile”, nonostante possa poggiare su dati falsi.

Come difendersi dalle notizie false dell’AI e dalla disinformazione

Alla luce dei risultati evidenziati nello studio summenzionato, è naturale pensare a qualche strategia per difendersi dalle notizie false promosse dall'AI. Il consiglio che vi diamo è quello di seguire sempre queste due dritte.

- Verificate sempre risalendo alle fonti della notizia: questa potremmo definirla la “regola aurea” quando ci si informa online, che lo si faccia direttamente interrogando un chatbot AI o consultando un giornale online ritenuto affidabile. Non dovreste mai mancare di verificare fatti, cifre, dati e affermazioni. Tanto per fare un esempio, se l'AI riassume una citazione tratta da una certa fonte online, sarebbe meglio porsi simili domande: la parafrasi della citazione è corretta? Chi ha fatto questa dichiarazione? In che contesto? La citazione integrale permette di dare una chiave di lettura differente a una frase estrapolata dal contesto? Naturalmente, per rispondere a tutti questi interrogativi è essenziale fare ricerche risalendo alla fonte originale contenente la dichiarazione, il che è essenziale per non cadere vittima della disinformazione.

- Condividete con altri, solo se siete sicuri della veridicità di una notizia: dato che le fake news vivono di condivisioni e ricondivisioni da parte degli utenti meno accorti, quando una certa notizia è dubbia, meglio non condividerla. In questo modo, contribuirete a spezzare la catena della disinformazione.

;Resize,width=767;)

;Resize,width=578;)

;Resize,width=767;)

;Resize,width=727;)

;Resize,width=727;)

;Resize,width=727;)